시작하기 앞서

최근 ChatGPT, Gemini 등 대규모 언어 모델(LLM)이 화제입니다.

하지만, 이런 서비스들은 대부분 클라우드 기반이라 인터넷 연결이 필수이고, 개인 정보 유출 우려도 있습니다.

그로 인해서 생성형 AI 차단을 기업이나 나라에서 현재 많이 실행중입니다.

하지만 Ollama를 사용하면 내 컴퓨터에 로컬 LLM을 구축하여, 인터넷 없이도, 개인 정보 걱정 없이 AI 모델을 마음껏 활용할 수 있습니다. (야호)

이 글은 이런 분들께 추천합니다 : )

- 로컬 LLM이 무엇인지 궁금하신 분

- Ollama를 사용하여 내 PC에 AI 모델을 설치하고 싶은 분

- 개인 정보 유출 걱정 없이 AI 모델을 활용하고 싶은 분

- 나만의 AI 비서를 만들어보고 싶은 개발자, 연구자

LLM 이란?

LLM은 ' Large Language Model' 의 약칭으로 거대 언어 모델(LLM, Large Language Model)이라는 뜻을 가지고 있습니다.

ChatGPT, Bard와 같이 엄청난 양의 텍스트 데이터를 학습하여 인간처럼 자연스러운 문장을 생성하고, 질문에 답하고, 심지어 창작까지 가능한 모델들이죠.

하지만 이런 LLM들은 대부분 클라우드 기반으로 작동하기 때문에 인터넷 연결이 필수적이고, 때로는 응답 속도가 느리거나 개인 정보 보호에 대한 우려가 있을 수 있습니다.

이러한 문제점을 해결할 수 있는 대안으로 앞의 두글자를 더 추가한 '로컬 LLM'이 떠오르고 있습니다.

로컬 LLM은 말 그대로 개인의 컴퓨터(PC, 노트북, 스마트폰 등)에 직접 설치하여 사용하는 LLM을 의미합니다.

마치 워드나 엑셀 프로그램을 설치하듯이 말이죠! , 로컬 = 자기 PC

로컬 LLM, 왜 주목해야 할까요?

- 인터넷 연결 없이 사용 가능: 클라우드 기반 LLM과 달리, 로컬 LLM은 인터넷 연결 없이도 작동합니다. 따라서 네트워크 환경이 불안정한 곳에서도 자유롭게 사용할 수 있고, 비행기 모드에서도 작업이 가능합니다.

- 빠른 응답 속도: 내 컴퓨터에서 직접 실행되기 때문에 서버와의 통신 과정이 없어 응답 속도가 매우 빠릅니다. 실시간으로 대화하거나 글을 작성할 때 훨씬 쾌적한 경험을 제공합니다. (대신 PC 성능이 좋아야 합니다 T.T)

- 강력한 개인 정보 보호: 모든 데이터가 내 기기 내에서 처리되므로 개인 정보 유출 걱정 없이 안심하고 사용할 수 있습니다. 민감한 정보를 다루는 작업에 특히 유용합니다.

- 맞춤형 모델 구축: 내 데이터와 필요에 맞게 LLM을 미세 조정(fine-tuning)하여 나만의 특화된 모델을 만들 수 있습니다. 특정 분야에 대한 전문 지식을 학습시키거나, 개인적인 글쓰기 스타일을 반영하는 등 다양하게 활용할 수 있습니다.

- 비용 절감: 클라우드 기반 LLM은 사용량에 따라 비용이 발생할 수 있지만, 로컬 LLM은 초기 설치 비용 외에 추가 비용이 거의 없습니다.

그럼 이제 로컬 LLM을 구동하기 위해서는 또다른 도구가 필요합니다! (로컬 LLM = 재료)

Ollama 란?

Ollama는 로컬 환경에서 LLM을 실행할 수 있게 해주는 오픈 소스 프로젝트(도구)입니다. (로컬 LLM = 재료)

Ollama는 사용자에게 친화적인 환경을 제공하며, 복잡한 설정 없이도 다양한 LLM 모델을 손쉽게 실행하고 관리할 수 있게 해줍니다.

Ollama를 사용하면 다음과 같은 장점을 누릴 수 있습니다.

- 프라이버시 보장: 내 데이터가 외부 서버로 전송되지 않아 개인 정보 유출 걱정이 없습니다.

- 오프라인 사용: 인터넷 연결 없이도 AI 모델을 사용할 수 있습니다.

- 무료 & 오픈 소스: 누구나 무료로 자유롭게 사용할 수 있습니다.

- 다양한 모델 지원: Llama 2, Mistral, Gemma 등 다양한 오픈 소스 LLM을 지원합니다. (최신 모델 지원)

- 쉬운 설치 및 사용: 간단한 명령어로 설치하고, 직관적인 인터페이스로 사용할 수 있습니다.

- GPU 가속 지원: 엔비디아 그래픽카드를 가지고 있다면 훨씬 빠른 속도로 사용할 수 있습니다.

Ollama 설치하기

Ollama는 Windows, macOS, Linux 등 다양한 운영체제를 지원합니다.

하지만 사실 이글을 보는 구독자분들께서는 일반 운영 체제인 Windows를 많이 사용하기 때문에 ,

본 포스팅은 Windows 운영 체제 기준으로 설명 드리도록 하겠습니다 : )

Ollama 공식 웹사이트에 접속후 , Windows 설치 파일을 다운로드합니다

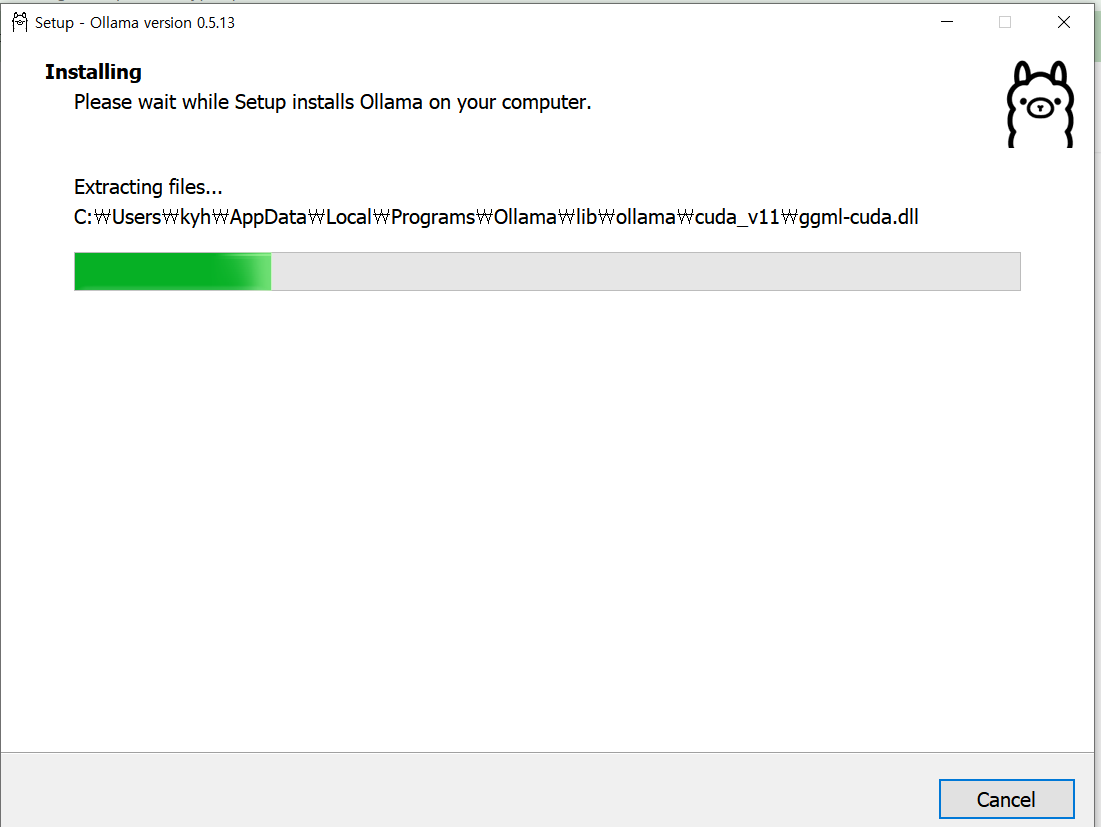

다운로드한 파일을 실행하고, 안내에 따라 설치를 진행합니다.

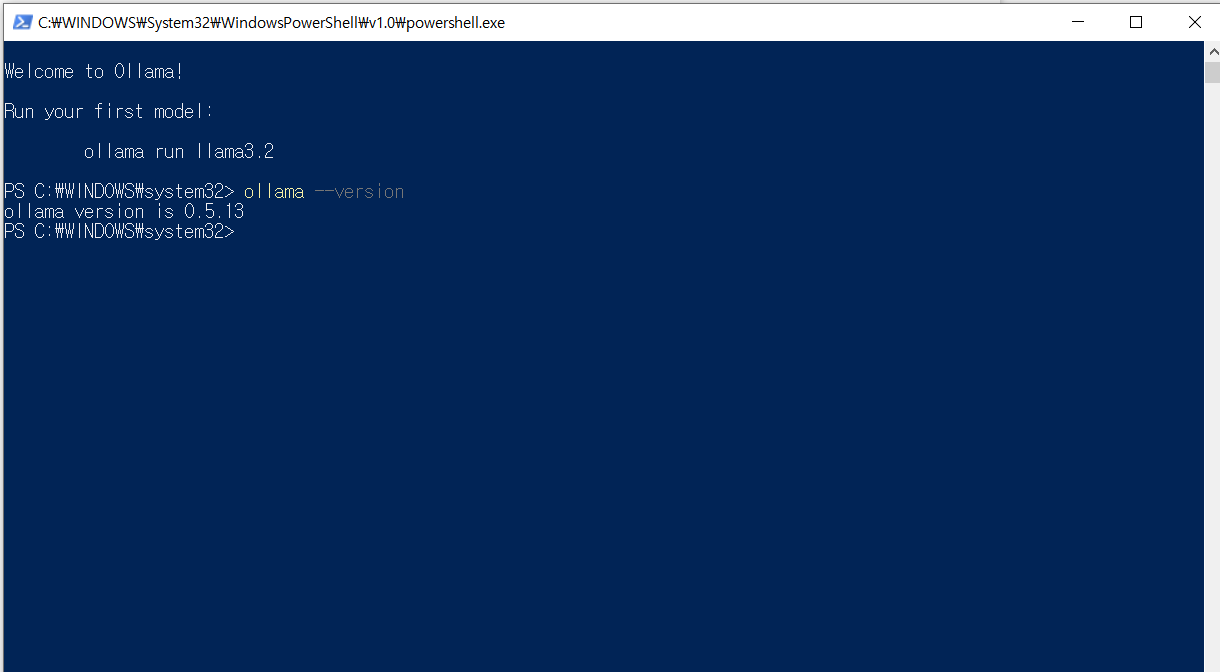

설치가 완료되면, 명령 프롬프트(cmd) 또는 PowerShell을 열고 아래 명령어를 입력하여 설치 여부를 확인합니다.

ollama --version

아래와 같이 설치된 버전이 나오면 정상적으로 설치된 상태임을 확인 하실 수 있습니다.

여기까지 LLM에 대한 설명과 Ollama 설치 방법에 대해 설명했습니다.

다음 글에서는 프로그램 수행 후 실행하는 방법과 사용법에 대해 상세하게 알려드리도록 하겠습니다.

그럼 다음 포스팅에 만나요 찡긋 >.~

'For 비전공, 비전문가 > AI' 카테고리의 다른 글

| 🤖 AI 모델, 어떤 기준으로 선택하는 것일까요? (3) | 2025.03.12 |

|---|---|

| 로컬 LLM 끝판왕 Ollama , 나만의 AI 비서 만들기 - 2 (1) | 2025.03.09 |

| GPT-4보다 강력? 중국산 AI 딥시크의 충격적인 성능! (3) | 2025.03.07 |

| ❇️ 비전공자도 활용하기 쉬운 Chat GPT, Gemini 프롬프트 작성법_2 (0) | 2025.03.04 |

| ❇️ 비전공자도 활용하기 쉬운 Chat GPT, Gemini 프롬프트 작성법_1 (3) | 2025.02.28 |