안녕하세요!

Ollama에 대한 사용 방법과 예제를 이전 포스팅에서 보여줬었는데요,

터미널에 대한 사용법이 익숙치 않아 불편함을 느끼시지 않으셨나요??

https://sexymakemoney.tistory.com/14

로컬 LLM 끝판왕 Ollama , 나만의 AI 비서 만들기 - 2

이전 포스팅에서는 로컬 환경에서 LLM을 실행할 수 있게 해주는 오픈 소스 프로젝트(도구)인 Ollama를 설치했는데요,이제 본격적으로 사용하는 방법에 대해 알려드리도록 하겠습니다 :) https://sexy

sexymakemoney.tistory.com

기본적으로 커맨드 라인 인터페이스로 제공되어 일반 사용자에게는 다소 진입 장벽이 있습니다.

그래서 오늘은 좀더 친숙하게 Ollama를 GUI로 구현하여 ChatGPT와 같은 친숙한 채팅 인터페이스로 사용하는 방법에 대해 알아가보도록 하겠습니다 :)

GUI 구현

Ollama의 GUI를 구현하는 몇 가지 방법이 있습니다

1. OpenWebUI - 가장 인기 있는 웹 기반 인터페이스

OpenWebUI는 웹 브라우저에서 사용할 수 있는 Ollama 인터페이스로, ChatGPT와 매우 유사한 디자인을 제공합니다.

설치가 간단하고 다양한 기능을 제공하여 초보자에게 가장 추천하는 옵션입니다.

2. ollama-webui - 커스터마이징이 뛰어난 웹 인터페이스

Vue.js로 개발된 이 프로젝트는 사용자 정의 옵션이 많고, 세부 설정을 원하는 사용자에게 적합합니다.

디자인이 깔끔하고 반응형이라 모바일에서도 잘 작동합니다.

3. OllamaHub - 데스크톱 전용 애플리케이션

브라우저 대신 독립된 프로그램으로 실행되는 GUI로, 컴퓨터에 직접 설치하여 사용합니다.

웹 브라우저를 열지 않고도 바로 사용할 수 있어 편리합니다.

위의 3가지 방법 중 가장 쉽고 인기 있는 'OpenWebUI를 설치'하는 방법을 상세히 알아보겠습니다.

OpenWebUI 설치하기

OpenWebUI를 설치하는 방법은 크게 두 가지가 있습니다.

바로 Docker를 사용하는 방법과 관련 프로그램들과 환경에 대해서 직접 설치하는 방법입니다.

비전공자에게는 Docker를 사용하는 방법이 더 간단하므로 이 방법을 중점적으로 설명하겠습니다.

Doker란?

애플리케이션을 컨테이너(Container) 라는 독립적인 환경에서 실행할 수 있도록 해주는 컨테이너화(Containerization) 기술 입니다.

도커를 사용하면 앱과 필요한 모든 환경(설정, 라이브러리 등)을 한 박스에 담아서 어디서든 똑같이 실행할 수 있습니다.

쉽게 말해,어디서든 똑같이 실행되는 '앱 포장 상자'라고 생각하면 됩니다.

먼저 아래의 사이트에서 Docker Desktop을 다운로드하고 설치합니다.

https://www.docker.com/products/docker-desktop/

Docker Desktop: The #1 Containerization Tool for Developers | Docker

Docker Desktop is collaborative containerization software for developers. Get started and download Docker Desktop today on Mac, Windows, or Linux.

www.docker.com

설치가 완료되면, 아래의 아이콘 모양을 클릭 후 Docker Desktop을 실행시켜주세요.

초기에 프로그램을 실행하게 되면, 아래와 같이 starting 상태가 잠시 지속 될 수 있습니다.

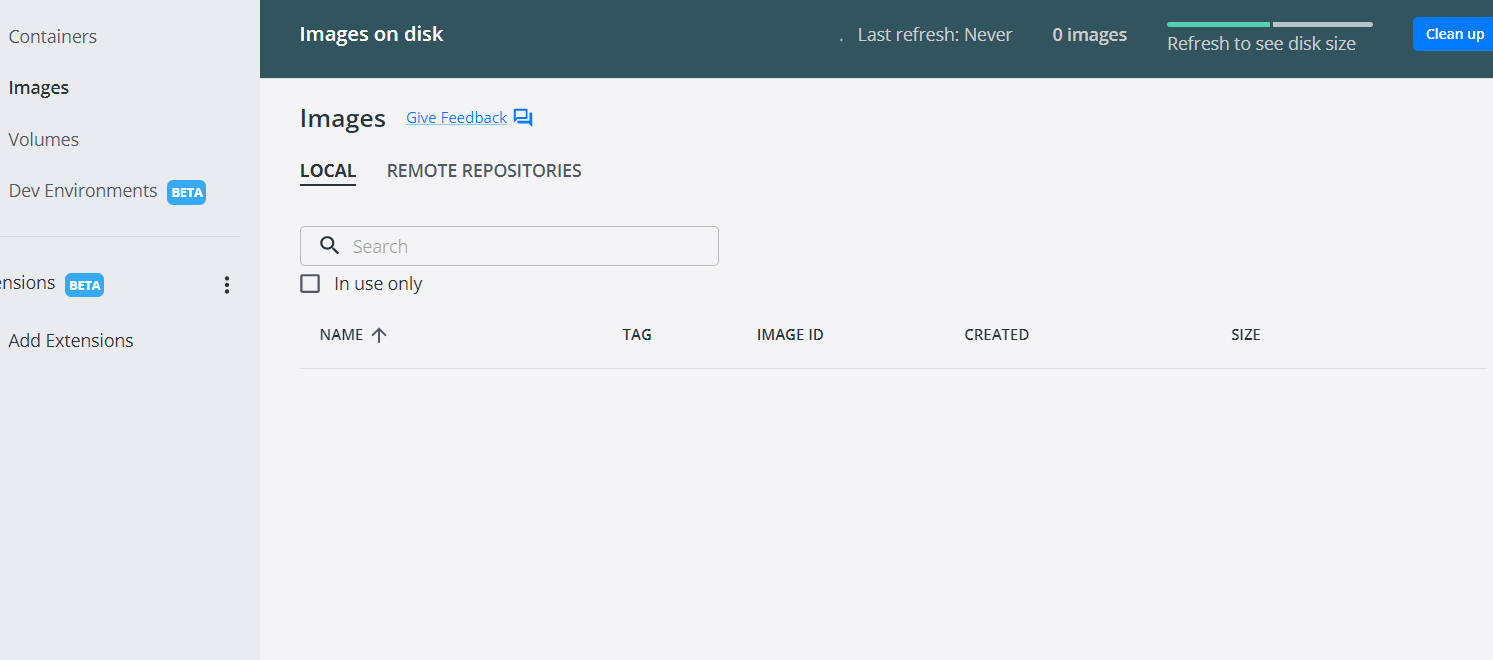

그 이후 아래와 같은 화면으로 변경되면 명령 프롬프트창(cmd )을 열어줍니다.

다음 명령어를 복사하여 붙여넣고 실행합니다:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:latest

프로그램이 다운로드가 완료되면 프롬프트는 아래와 같이 complete로 변경됩니다.

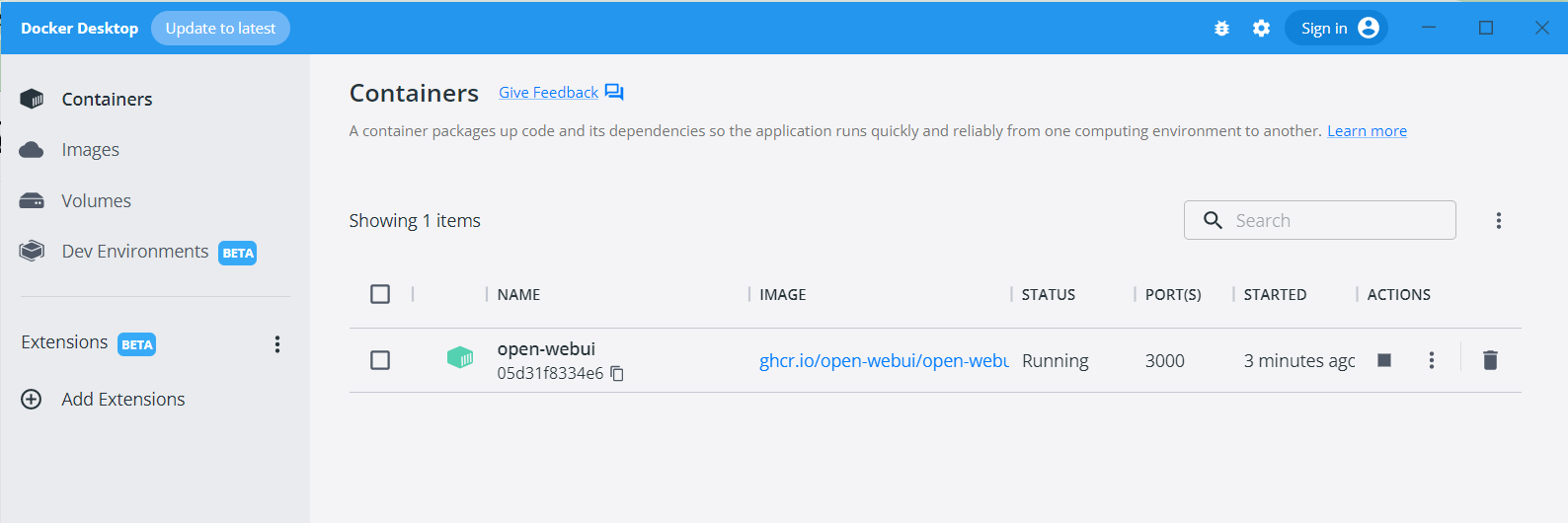

다운로드가 완료되면, 가상화 컨테이너인 Docker Desktop 프로그램 화면으로 다시 돌아가면 아래와 같이 container 항목에 새로 추가 된 부분을 확인 할 수 있습니다.

OpenWebUI 접속 및 초기 설정

설치가 완료되었으니, 이제 OpenWebUI에 접속하여 사용할 수 있습니다!

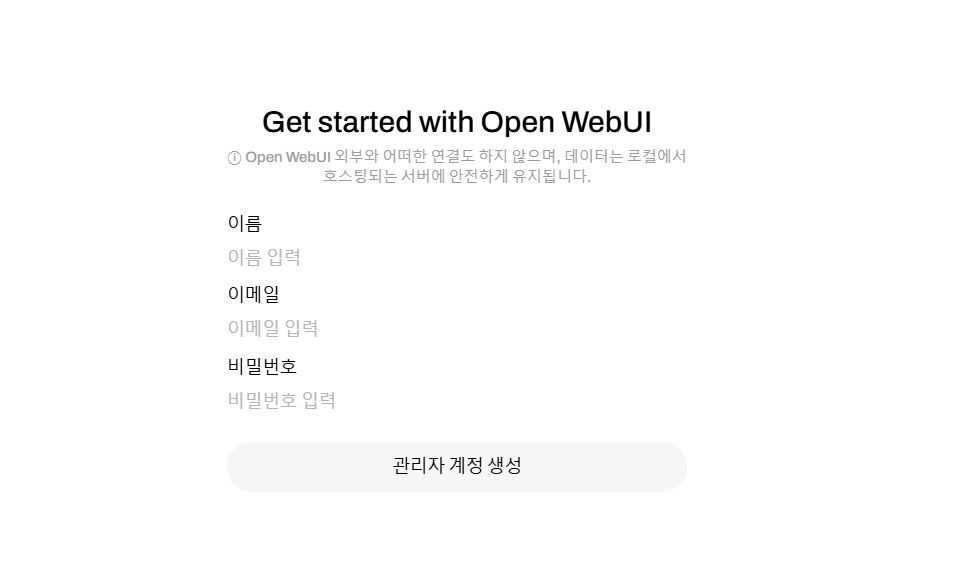

1. 웹 브라우저(Chrome, Edge, Firefox 등)를 열고 주소창에 http://localhost:3000을 입력합니다.

2. 처음 접속하면 초기 설정 화면이 나타납니다.

( 만약에, Ollama 서버 주소를 입력하라고 나타나면, 기본값인 http://localhost:11434를 입력해주세요)

3. Get Satarted 버튼을 클릭해서 관리자 계정 정보를 생성해주세요.

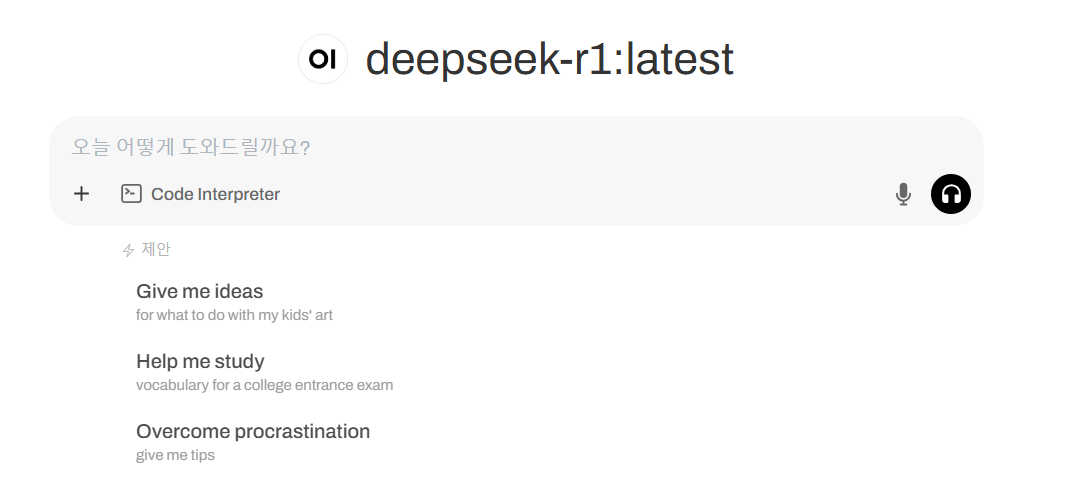

4. 관리자 계정이 생성 되면, 메인 채팅 인터페이스로 이동하게 됩니다.

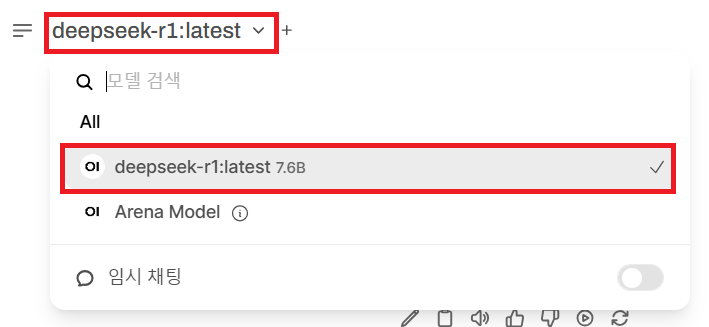

저는 이전에 'deepseek-r1' 으로 모델을 설치했기때문에 해당 모델이 보여지고 있습니다.

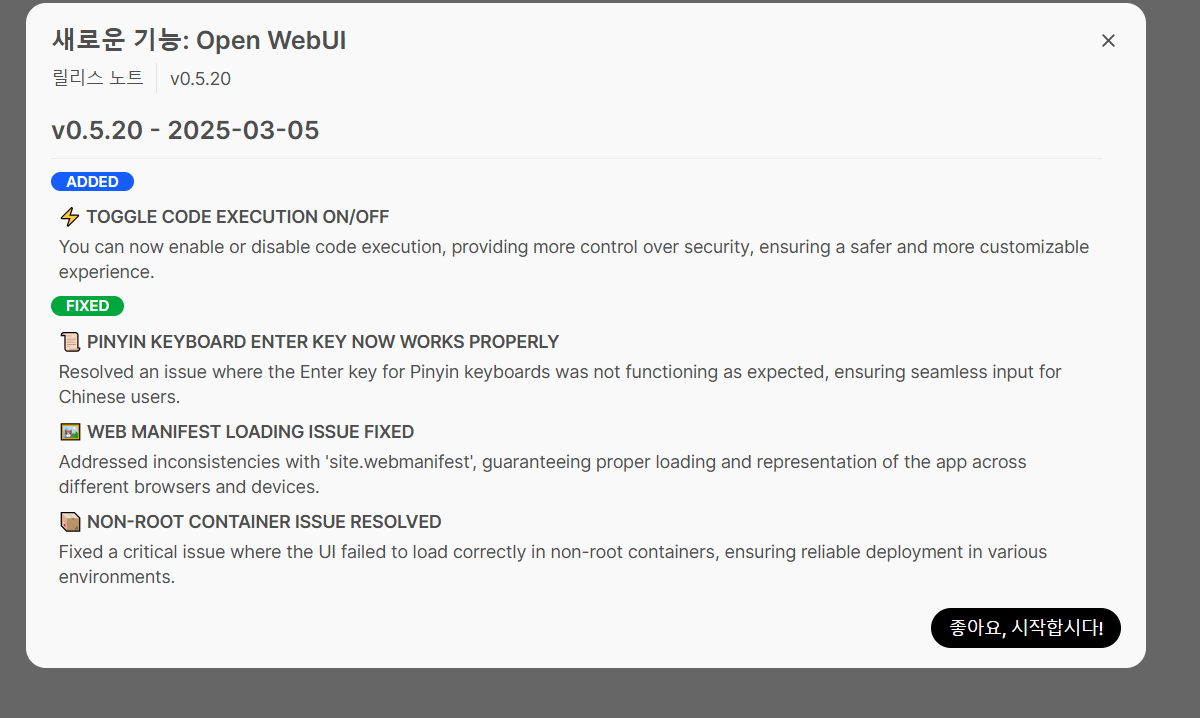

이렇게 공지사항 같이 추가된 부분과 수정된 부분도 모달창으로 나타내주고 있습니다 :) 세상 친철 하네요 ㅎㅅㅎ

OpenWebUI 기본 사용법

이제 그럼 첫 대화를 시작해보도록 하겠습니다.

화면 중앙에 있는 채팅 창에 질문이나 명령을 입력합니다.

"안녕하세요, 자기소개 부탁해요."

"간단한 파이썬 계산기 코드를 작성해줄래요?"

"인공지능에 대해 알려주세요."

메시지를 보내면 AI가 응답을 생성하는 모습을 볼 수 있습니다.

시간이 좀 지나고 난 뒤, 답변을 생성한 내역을 확인 할 수 있습니다.

다만, 터미널로 바로 질문을 하는 것보다 GUI로 질문을 하면 처리 시간이 조금 더 소요되는 점 참고해주세요!

터미널은 바로 명령어가 전달 되지만 GUI는 화면에 입력한 내용을 localhost를 통해 모델로 전달 되기때문에 단계가 하나 더 생겨 처리 속도가 조금 느릴 수 있습니다.

그후 AI에서 제일 중요한 모델을 선택 및 추가하는 방법에 대해 알아보도록 하겠습니다.

화면 좌측 상단에 있는 모델 선택 드롭다운 메뉴를 클릭합니다.

아래와 같이 설치된 모델 목록이 표시됩니다. 기본적으로는 현재 설치 된 모델인 'deepseek-r1'이 표시됩니다.

만약, 다른 모델을 사용하고 싶다면, 터미널에서 ollama pull [모델명] 명령어로 먼저 다운로드 후 선택해주세요!

- 추천 모델 :

llama2: 범용적인 대화와 정보 제공 (3-4GB)

mistral: 작은 크기로도 우수한 성능 제공 (4GB)

gemma:7b: Google의 최신 오픈 소스 모델 (4GB)

codellama:7b: 코딩에 특화된 모델 (4GB)

OpenWebUI 고급 활용법

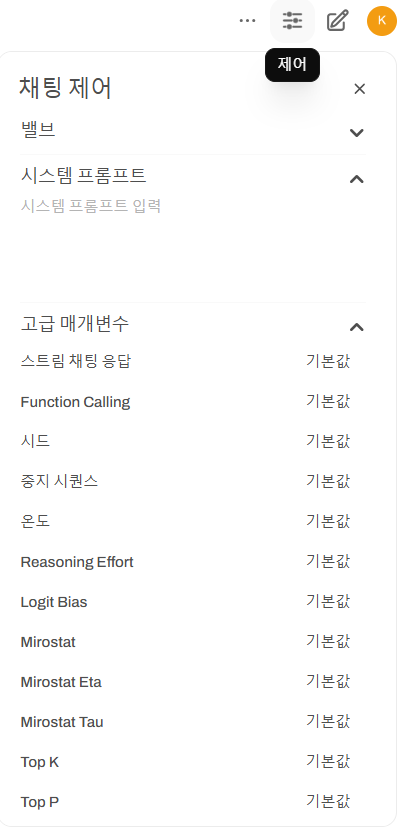

1. 대화 설정 옵션 설정

화면 우측 상단의 설정 아이콘을 클릭해주세요.

다양한 설정 옵션을 확인할 수 있습니다.

온도(Temperature): 값이 높을수록 창의적이지만 부정확할 수 있는 응답을 생성합니다. (기본값: 0.8)

최대 길이(Max Length): 응답의 최대 토큰 수를 설정합니다. (기본값: 4096)

시스템 프롬프트: AI에게 기본적인 지시사항을 설정할 수 있습니다.

2. 시스템 프롬프트 활용하기

시스템 프롬프트는 특정 역할이나 전문 분야에 맞춰 AI를 조정하고, AI의 동작 방식을 결정하는 중요한 설정입니다.

해당 역할에 대한 요구 사항에 대해 시스템이 자동으로 프롬프트에 추가합니다.

시스템 프롬프트 예시:

- 프로그래밍 도우미: "당신은 숙련된 프로그래머입니다. 코드 작성과 문제 해결에 대한 질문에 정확하고 실용적인 답변을 제공해주세요."

- 작문 도우미: "당신은 창의적인 작가입니다. 사용자의 글쓰기를 돕고 아이디어를 제안해주세요."

- 한국어 교사: "당신은 한국어 교사입니다. 문법과 표현을 정확하게 사용하고 학습자의 질문에 자세히 답변해주세요."

3. AI의 응답 생성 속도 조정하기

만약에 AI 모델의 응답 생성 속도가 너무 느리다면, 기존보다 더 작은 모델을 사용해보는 것을 권장드립니다.

(llama2:7b 대신 mistral:7b-instruct 등)

설정에서 최대 길이(Max Length)를 줄여보세요.

그래픽 카드(GPU)가 있다면 Ollama가 이를 활용하고 있는지 확인하세요.

마무리

OpenWebUI는 Ollama를 통해 로컬에서 실행되는 AI 모델을 쉽게 사용할 수 있게 해주는 훌륭한 도구입니다. :)

이 가이드를 통해 비전공자분들도 쉽게 OpenWebUI를 설치하고 활용할 수 있었으면 좋겠습니다.

다양한 모델을 실험해보고, 시스템 프롬프트도 조정하고, 여러 템플릿을 만들면서 여러분만의 AI 비서를 구축해보세요.

기술적인 문제가 있다면 아래 사이트 OpenWebUI의 GitHub 페이지나 온라인 커뮤니티에서 도움을 구할 수 있습니다.

https://github.com/open-webui/open-webui

GitHub - open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...)

User-friendly AI Interface (Supports Ollama, OpenAI API, ...) - open-webui/open-webui

github.com

Open WebUI

Open WebUI Community is currently undergoing a major revamp to improve user experience and performance ✨

openwebui.com

AI의 능력을 최대한 활용하여 더 효율적이고 창의적인 작업을 즐기시길 바랍니다! :) 춍춍

'For 비전공, 비전문가 > AI' 카테고리의 다른 글

| 🎨 프롬프트 하나로 비교하는 AI 이미지 생성 모델: Midjourney부터 Flux까지 (1) | 2025.03.24 |

|---|---|

| ✨ AI 모델 활용과 프롬프트: AI 초보자도 전문가처럼 일하는 비법 🤖 (2) | 2025.03.23 |

| 🤖 AI 모델, 어떤 기준으로 선택하는 것일까요? (3) | 2025.03.12 |

| 로컬 LLM 끝판왕 Ollama , 나만의 AI 비서 만들기 - 2 (1) | 2025.03.09 |

| 로컬 LLM 끝판왕 Ollama , 나만의 AI 비서 만들기 - 1 (2) | 2025.03.09 |